andreusk – stock.adobe.com

Uprkos žarkom veštačkog inteligencije u Velikoj Britaniji, još uvijek postoji mala smislena transparentnost oko opsega raspoređivanja tehnologije u cijeloj javnim uslugama

Od

- Jasleen Chaggar,Big Brother Watch

Objavljeno: 26. februara 2025. godine

Prošli mjesec, Vlada Velike Britanije najavila je planove za “mainline AI into the veins” nacije i “revolutionise how AI is used in the public sector.” Unatoč tome, vladina odjela, vladini odjeli već godinama postavljaju temelj ovog usvajanja, eksperimentišući sa algoritamskim alatima iza zatvorenih vrata.

Ovaj spektar umjetne inteligencije (AI) povlačenje žica na odluke o našem zdravlju, blagostanju, obrazovanju i pravdi bez našeg znanja ili nadzora je kafkazinska noćna mora. Tek sada počinjemo da se slikamo kako se koristi.

Od 2024. godine, Odjel za nauku, inovacije i tehnologiju zahtijevali su sve odjele središnje države da objave jasne informacije o njihovoj upotrebi algoritamskih alata na algoritamskom centru za snimanje transparentnosti (ATRS). Međutim, do sada su samo 47 evidencija objavilo razne vladine odjeljenja – od kojih je preko polovine objavljene od početka ove godine.

Ovo je nesigurnost prema transparentnosti posebno alarmantno, s obzirom na izvještaje da se piloti AI namijenjeni za socijalnu zaštitu mirno prehlađuju zbog “frustrations and false starts.”

Kritične odluke

Nedavni dodaci ATRS-u otkrivaju da vlada koristi algoritamske alate za utjecaj na kritične odluke, uključujući i koje koristi podnosioci zahtjeva kvalificira se za dodatak za zapošljavanje i podršku (ESA), koji školarci su u opasnosti od kojih su školarci u riziku da postanu “NEET” (ne u obrazovanju, zapošljavanju ili obuci), te rečenice i uslovi licence koje treba dati prekršiteljima.

Sa tako malo dostupnim informacijama vrijedi pitati: koliko vladinih odjela tajno koristi algoritme za donošenje odluka o našem životu?

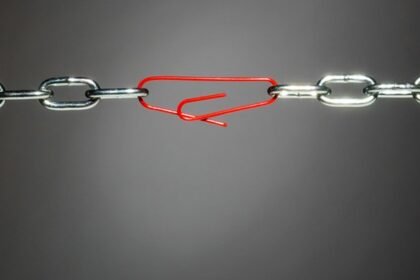

Istovremeno, kao što to gura usvajanje AI u javnom sektoru, vlada gura putem zakonodavstva koja bi oslabila postojeće zaštite od automatiziranog donošenja odluka (Add).

Uredba o općim podacima u Velikoj Britaniji (GDPR) zabranjuje bilo koji isključivo automatizirani proces koji donose značajne odluke. To nas štiti od “computer says no” Scenariji gdje se suočavamo sa štetnim ishodima bez stvarnog razumijevanja obrazloženja iza njih. Korištenje podataka i pristupa (Duab) (Duab) trenutno napreduju kroz Dom Commons uklonili bi ovu zaštitu iz ogromnog prostora procesa donošenja odluka, ostavljajući nas izložene diskriminaciji, pristranosti i grešci bez obzira na to da ga izazovemo.

Predlog zakona omogućio bi isključivo automatizirano odlučivanje, pod uvjetom da se ne obrađuje “special category data”. Ova posebno osjetljiva podkategorija ličnih podataka uključuje biometrijske i genetske podatke; podaci koji se tiču zdravlja osobe, seksualnog vijeka ili seksualne orijentacije i podatke koji otkrivaju rasno ili etničko porijeklo; politička vjerska ili filozofska uvjerenja; i članstvo u sindikatu.

Iako stroge zaštite za ove posebne kategorije podataka su razumne, automatizirane odluke koristeći podatke ne-posebne kategorije mogu i dalje proizvoditi štetne i diskriminatorni ishodi.

Na primjer, holandski prednosti za djecu uključivao je korištenje algoritma samo-učenja koji su nesrazmjerno označili porodice sa niskim primanjima i etničke manjine kao rizično od prevare uprkos tome da ne obrađuju podatke posebne kategorije. Skandal je gurnuo hiljade ljudi u siromaštvo nakon što su pogrešno istraženi i prisiljeni da vrate dugove koje nisu duguli – tjeskoba situacije izazvala je da se odnosi i čak vodio ljude da bi se razbili i čak vodio ljude da pohađaju vlastite živote.

Neravnopravni ishodi

Bliži dom, skandal s ocjenom razine tijekom Coude Pandemic proizvela je nejednake rezultate između privatnog obrazovanih i državnih učenika i izazvao javno bijes uprkos sistemu ocjenjivanja ne oslanjajući se na obradu podataka o posebnom kategorijom.

Podaci ne-posebne kategorije mogu se djelovati i kao proxy za podatke o posebnim kategorijama ili zaštićene karakteristike. Na primjer, Durham Constabulary’s Alat za procjenu štete (HART) procijenio je rizik od prekršaja prekršitelja obradom 34 kategorije podataka, uključujući dvije vrste stambenih poštanskih brojeva. Upotreba podataka o poštanskim brojevima u prediktivnom softveru riskirala je ugradnju postojećih pristranosti prenamjerenog rada u područjima društveno-ekonomskog nedostatka. Skidanje nekoliko zaštitnih mjera koje trenutno imamo rizik od još većeg katastrofa u stilu horizonta.

Važno je da se ne smatra automatiziranom ako postoji smislena ljudska uključenost. U praksi bi moglo izgledati kao odjel za HR pregled odluka AI alata za zapošljavanje prije nego što odlučimo o razgovoru ili banke koristeći automatizirani alat za pretraživanje kredita kao jedan faktor prilikom odlučivanja hoće li dati kredit podnositelju zahtjeva. Te odluke ne privlače zaštite koje se odnose na isključivo adm.

Javni sektor trenutno zaobilazi neke zabrane adm-a ukazujući na unos ljudskog unosa u procesu donošenja odluka. Međutim, puko postojanje ljudske petlje ne mora nužno jednako izjednačiti “meaningful”Uključenost.

Na primjer, Odjel za rad i penzije (DWP) kaže da je nakon svog ESA internetskog alata za podudaranje ponuda odgovarajući profil “agent performs a case review” u konačnici odlučiti da li bi se zahtjev trebao dodijeliti.

Međutim, procjena rizika odjela također priznaje da bi alat mogao smanjiti smislenost odluke ljudskog agenta ako jednostavno prihvate algoritamsku prijedlog. Ovo “automation bias” Znači da mnoge automatizirane odluke koje imaju površno uključivanje ljudskog jezika koje ne predstavljaju više od gumenog žigovanja logike mašine, vjerovatno će proliti u javnom sektoru – bez privlačenja bilo koje zaštite od isključivo admi.

Smisleno sudjelovanje

Pitanje onoga što je smisleno ljudsko sudjelovanje nužno ovisno o kontekstu. Apelacioni sud Amsterdama utvrdio je da Uber-ova odluka do “robo-fire” Vozači nisu uključivali smisleni ljudski unos, jer vozači nisu bili dozvoljeni žalbu i Uber zaposleni koji su donijeli odluku nisu nužno imali nivo znanja na značajno oblikovanje ishoda izvan prijedloga mašine.

Očigledno je da je definicija smisla za jednu čovjeku razlikuje od tuđe. Duab daje državnom sekretaru za nauku, inovacije i tehnološke ekspanzivne moći da redefinira ono što bi moglo izgledati u praksi. To nam sve dovodi u rizik da budem izloženi automatiziranim odlukama koje su na površini koje su napeto odobrene od strane ljudi bez vremena, obuke, kvalifikacija ili razumijevanja kako bi mogli smisleno pružiti ulaz.

Jubilantski zagrljaj AI od strane Vlade Velike Britanije može biti znak vremena, ali neprovjereno širenje automatiziranog odlučivanja kroz javni sektor i slabljenje srodnih zaštita opasnost za sve nas.

Pročitajte više o umjetnoj inteligenciji, automatizaciji i robotici

-

DSIT stalni sekretar kaže da je potrebno više transparentnosti AI

Napisao: Sebastian Klovig Skelton

-

Lords raspravljaju o pristupu vlade automatiziranom odlučivanju

Napisao: Vipin Chimrani

-

Reguliranje automatiziranog donošenja odluka u računu podataka (upotrebe i pristupa)

Napisao: Lord Chris Holmes

-

Šta je stablo odluke u mašinskom učenju?

Napisao: Kinza Yasar